Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- PYTHON

- 온라인협업

- AWS

- 교차 엔트로피

- coding

- early stopping

- Git

- HTML

- mysql

- RLIKE

- 깃헙협업

- CSS

- leetcode

- github

- merge

- 선형 모형

- conflict

- 클라우드컴퓨팅

- 코딩공부

- elastic net

- 편향-분산 교환

- window function

- 버전충돌

- hackerrank

- L2정규화

- full request

- L1정규화

- sql

- branch

- programmers

Archives

- Today

- Total

Im between cherry

일반화, 용량, 과적합, 하이퍼파라미터, 검증, 편향-분산 교환 본문

일반화

- 학습된 결과를 새로운 데이터에 적용하는 것

- 일반화 오차: 일반화에서 발생하는 오차

- 보통 테스트를 통해 측정하므로 테스트 오차라고 함

용량

- 기계학습 모형이 표현할 수 있는 패턴의 범위

- 예시: y=wx, y=b, y=wx+b

과적합

- underfitting(과소적합): 데이터의 패턴이 모형이 표현할 수 있는 것보다 복잡

- overfitting(과대적합): 모형이 표현하는 패턴이 실제 데이터보다 복잡

- 과적합이 발생하면 일반화 오차가 커짐

No Free Lunch Theorem

(공짜 점심은 없다)

- 모든 가능한 문제들에 대한 기계학습 방법의 평균적 성능은 같다

- 항상 더 좋은 방법은 없음

- 단, 어떤 문제들에 대해서는 항상 더 좋은 방법이 있을 수 있다.

하이퍼파라미터

- 모형의 특성이나 학습 과정의 설정값들(예: epoch)

- 데이터로 학습하기 어렵거나, 학습시키기 바람직하지 않음

- 시행착오를 통해 설정

검증

- 기계학습에서 데이터를 train, validation, test로 나눔

- train: 모형의 파라미터를 학습

- validation: 모형의 하이퍼파라미터를 검증

- test: 모형의 성능을 테스트. 테스트 데이터는 최종 1번만 사용.

추정량의 편향과 분산

- 추정량: 샘플로부터 파라미터를 추정하는 방법

- 샘플에 따라 얻어진 추정값은 달라진다

- 편향: 추정값의 기댓값과 실젯값의 차이

- 분산: 추정값이 샘플에 따라 달라지는 정도

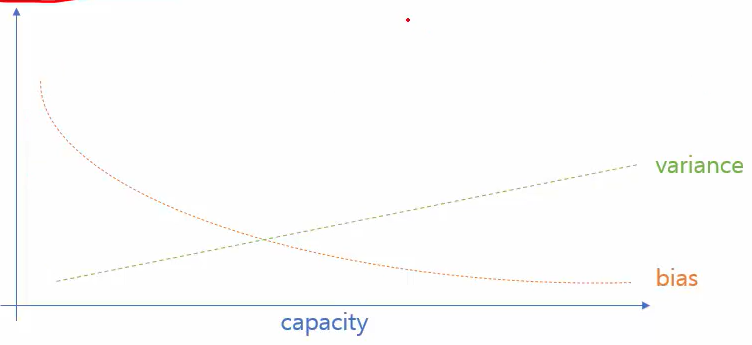

편향-분산 교환(Bias-Variance tradeoff)

- 모형의 일반화 오차 = 편향과 분산으로 구성

- 모형의 용량이 증가하면 편향은 감소, 분산은 증가

'데이터분석 > 텍스트 데이터 분석' 카테고리의 다른 글

| 정규화, 노름, L1정규화, L2정규화, Elastic net, Early Stopping (0) | 2020.11.29 |

|---|---|

| 감성 분석, 선형 모형, 로지스틱 회귀분석, 경사하강법, 교차 엔트로피 (0) | 2020.11.27 |

Comments